来源:

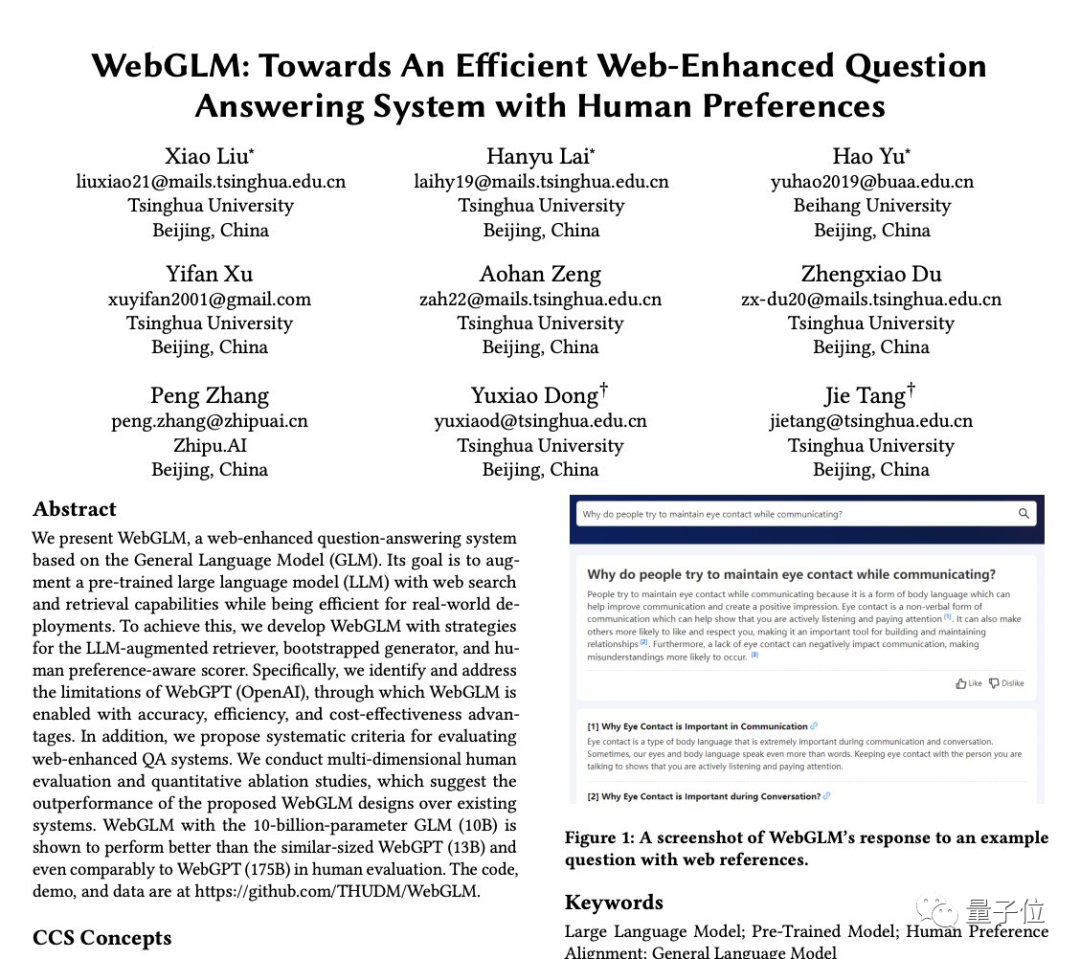

清华唐杰团队的新作品来了:

WebGLM,在线问答聊天机器人,100亿参数(论文入选号为KDD2023)。

你可以问它任何问题,然后它会列出网上相关文章的链接(比如* * * *,相关官网)并整理出答案。

你可以问它任何问题,然后它会列出网上相关文章的链接(比如* * * *,相关官网)并整理出答案。

例如:

ChatGPT的核心技术是什么?

或:

或:

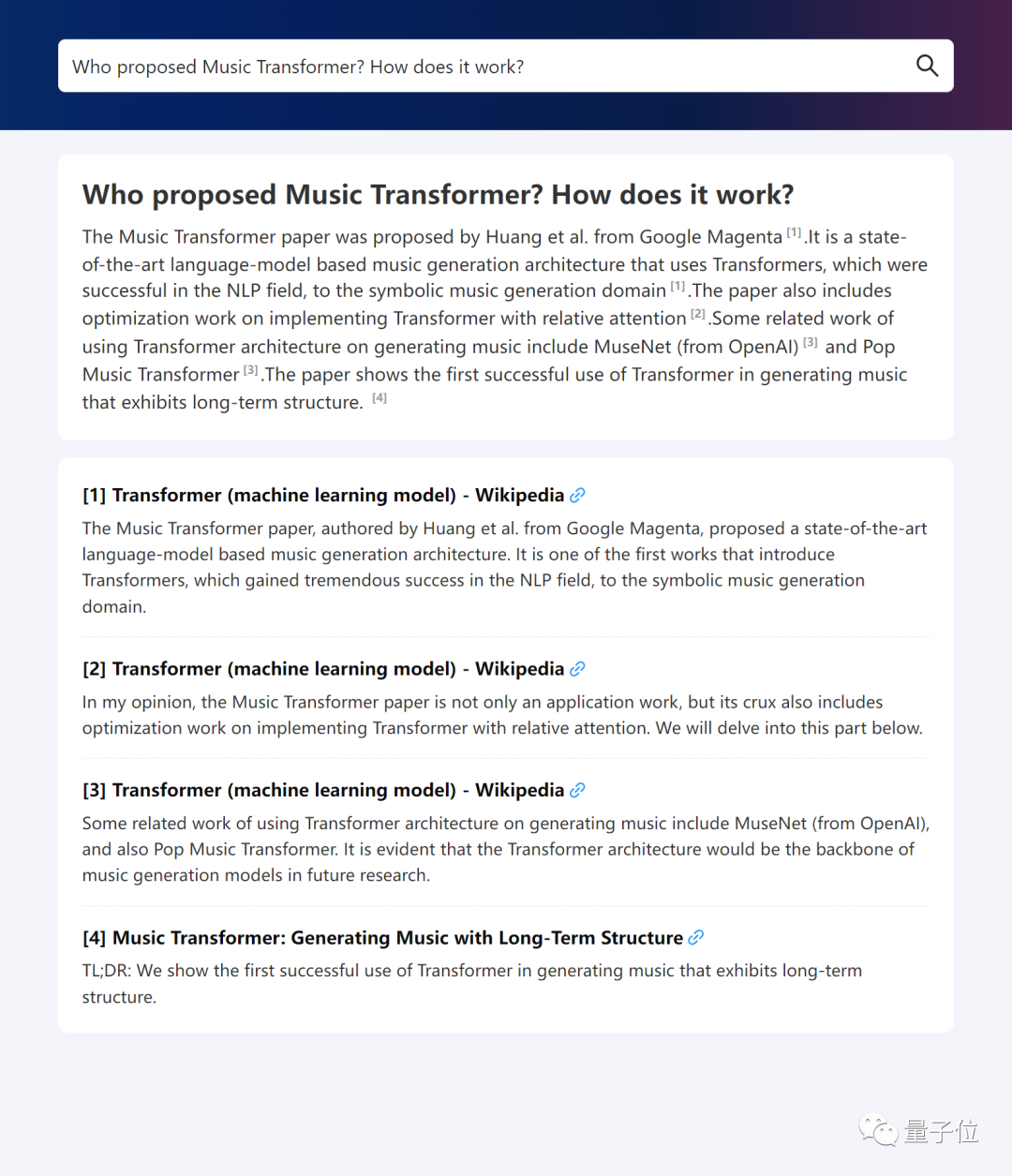

音乐变形金刚是谁提出的?它的原理是什么?

或:

或:

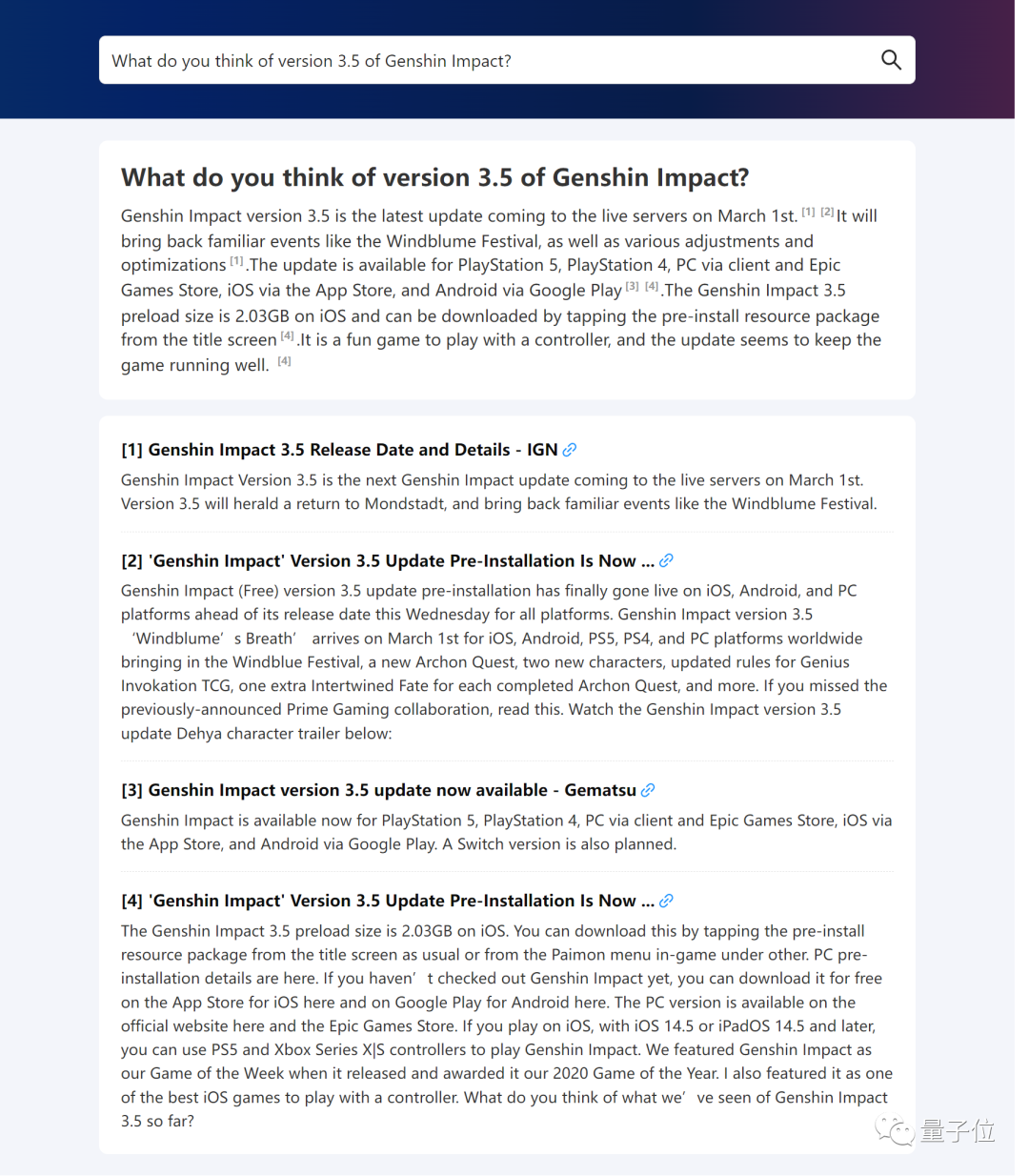

原神3.5版本怎么样?

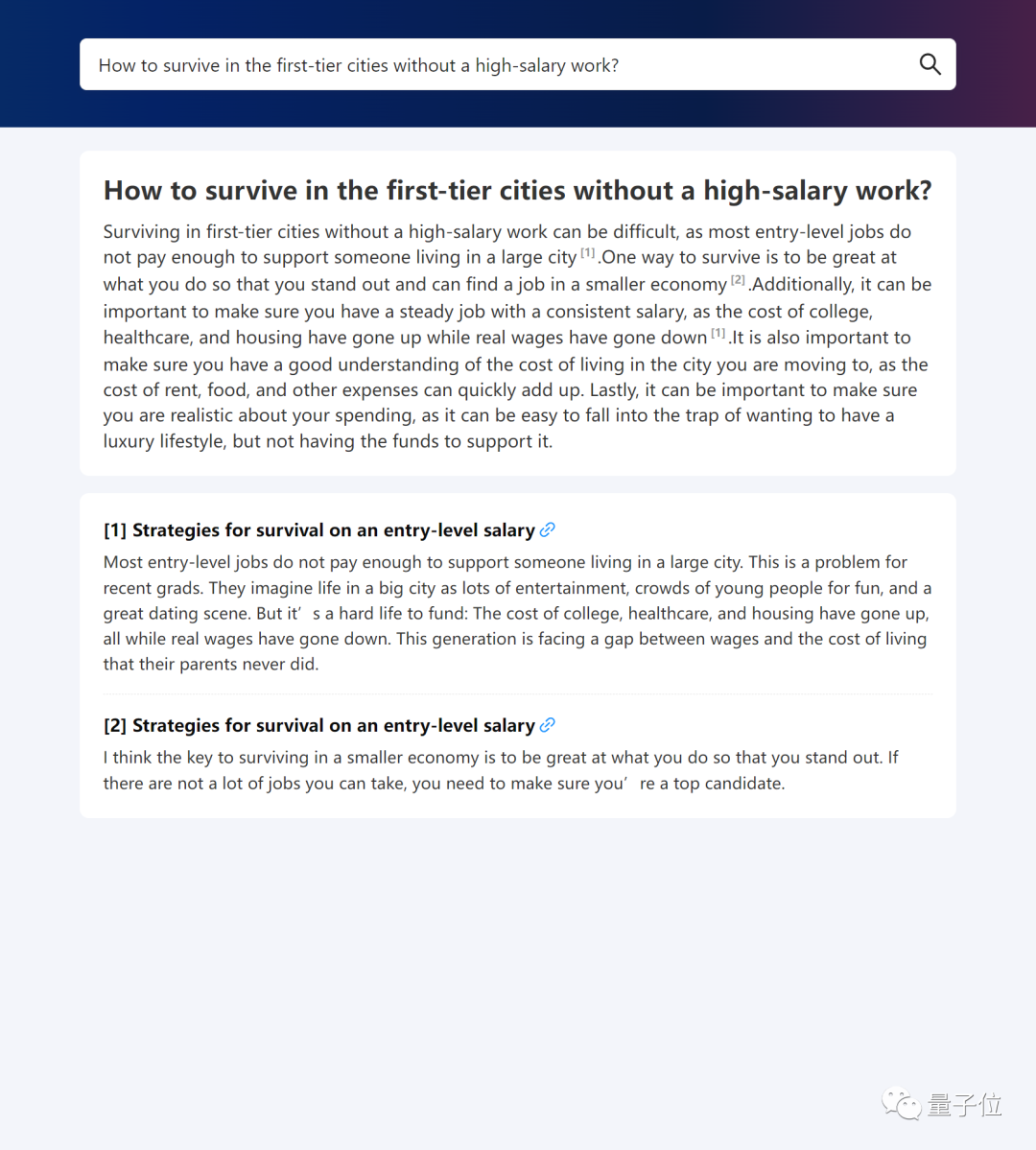

没有高薪工作怎么在一线城市生活?(手动狗头)

没有高薪工作怎么在一线城市生活?(手动狗头)

……

……

它能给出有理有据的答案。

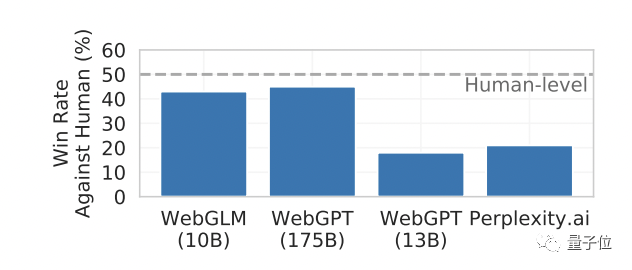

据介绍,在性能对比测试中,WebGLM的水平已经高于OpenAI的135亿参数的WebGPT,甚至可以与人体测评中1750亿参数的模型相媲美。

那么,它是怎么训练的呢?

那么,它是怎么训练的呢?

清华网校,可上网。

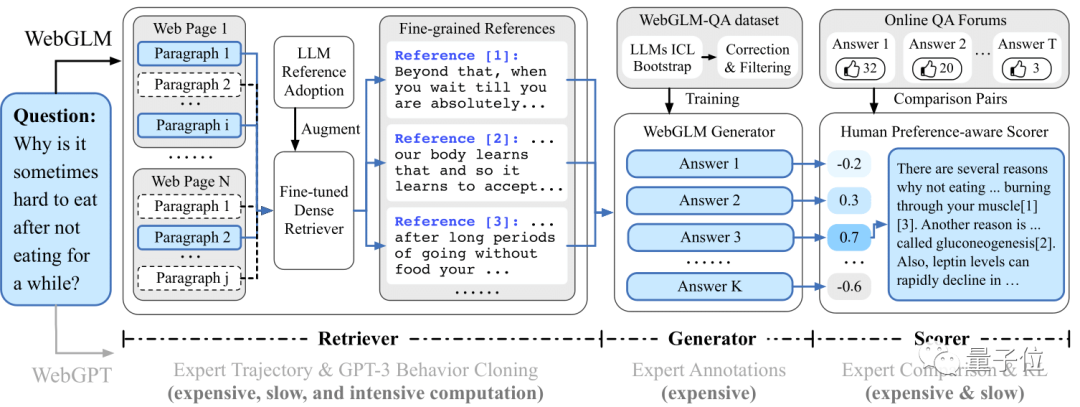

据介绍,WebGLM的目标是通过Web搜索和检索功能,增强预训练大语言模型,同时能够有效部署。

因此,作者基于三个策略展开。

首先是大型增强型寻回犬。

主要用于增强模型相关网络内容的检索能力,在给定的查询下找到相关的参考文献,以便后期更好更准确的回答问题。

它有两个阶段:粗粒度web搜索和细粒度LLM增强的密集检索。

随后是自举发生器。

它使用GLM(如清华发布的双语开源预训练模型GLM-130B)的能力来生成问题的答案并提供详细的答案。

使用这个生成器,作者得到了WebGLM-QA,一个LLM引导参考和一个长范围QA数据集。

通过上下文学习等策略进行清洗过滤,最终包括45k高质量过滤样本和83k噪声样本。

WebGLM的主干是在这个数据集上训练的GLM模型。

最后是基于人类偏好的评分者。

它通过优先考虑人类偏好而不是昂贵的专家反馈来评估生成的响应的质量,确保系统可以产生有用和有吸引力的内容。

以上三个组件最终依次构成了WebGLM的管道:

如您所见,只有三个模块,分别对应前面介绍的三个部分,其中:

如您所见,只有三个模块,分别对应前面介绍的三个部分,其中:

LLM enhanced retriever会将前五个最相关的页面作为参考源,让bootstrap生成器生成多个答案,最后评分器会选择最有可能符合人类偏好的一个作为最终输出。

超级性能OpenAI WebGPT

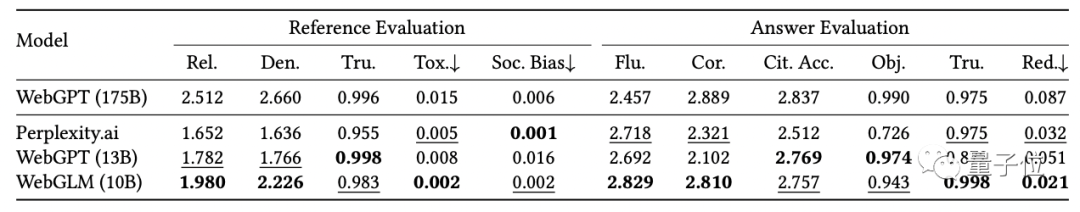

除了WebGLM本身,唐杰团队还提出了网络增强问答系统的评测标准,既包括参考文献,也包括最终答案。

其中,前者衡量五个维度:相关性、信息密度、真实性(无事实错误)、毒性(不包括暴力色情等信息)和社会偏见;后者衡量流畅性、正确性、引用准确性、客观性和冗余性。

他们对比评估了WebGPT(来自OpenAI,基于GPT-3进行微调)演示网站提供的272个问题,并招募了15名拥有硕士学位的志愿者进行评分。

最终结果如下:

("rel还有"书房"...分别对应以上10个指标。)

("rel还有"书房"...分别对应以上10个指标。)

可以看出,WebGLM的搜索结果虽然略低于WebGPT-175B,但远远好于perfluency . ai和WebGPT-13B(左边的参考评测)。

值得一提的是,WebGLM检索过程只使用了一些传统的基于词的算法和两个累计参数小于300M m的Contriever。

此外,WebGLM在计算性能和时间消耗上明显优于WebGPT-13B,与175B不相上下。

至于最终结果,WebGLM在流畅性、真实性和冗余性上得分最高,准确率指标接近WebGPT-175B,远高于perfluency . ai和WebGPT-13B。

作者认为,这表明WebGLM可以以更低的成本实现更高的性能。

部署和培训

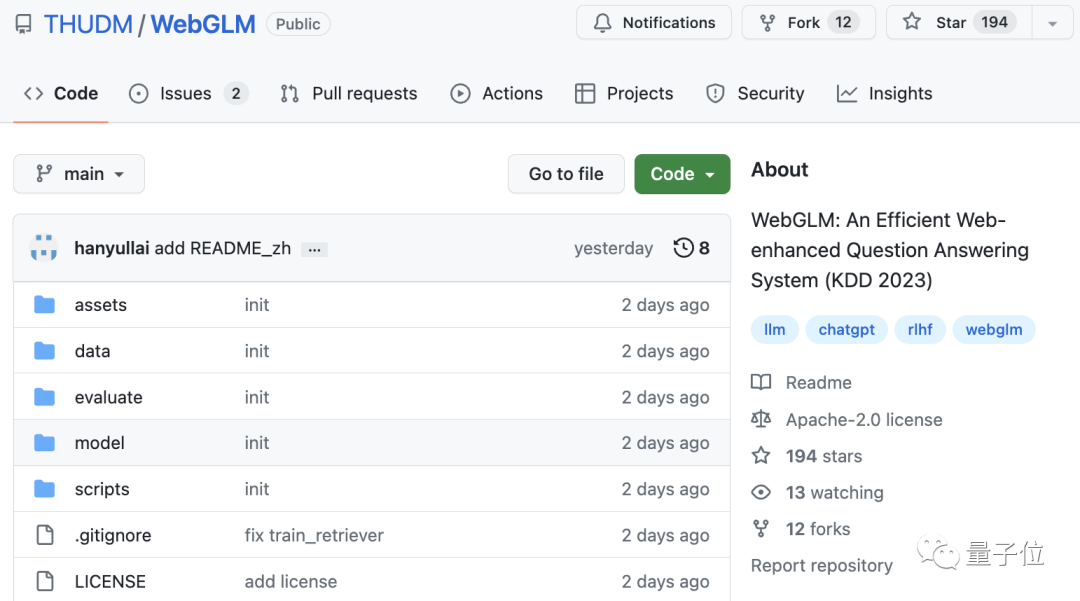

WebGLM发布时是开源的。

要部署它,需要从SerpAPI官网获取一个密钥,在搜索过程中可以使用这个密钥获取搜索结果。

要部署它,需要从SerpAPI官网获取一个密钥,在搜索过程中可以使用这个密钥获取搜索结果。

寻回犬的重量可以从清华云下载。

该模型有两种运行方式:一种是命令行界面,另一种是Web服务的形式,它包括两种可选的模型:WebGLM-2B和WebGLM-10B。

也可以自己训练WebGLM。官方已经提供了发生器和取回器的训练数据供下载~

地址:https://arxiv.org/abs//2306.07906.

GitHub主页:https://github.com/THUDM/WebGLM

温馨提示:注:内容来源均采集于互联网,不要轻信任何,后果自负,本站不承担任何责任。若本站收录的信息无意侵犯了贵司版权,请给我们来信(j7hr0a@163.com),我们会及时处理和回复。

原文地址"清华大学 唐杰,清华大学教授唐少杰":http://www.guoyinggangguan.com/qkl/142641.html。

微信扫描二维码关注官方微信

▲长按图片识别二维码