来源:方正公园

即使在新产品满天飞,商业文明正在被AI重建的时候,我们仍然不知道这些令人惊叹的技术是如何运作的。

AI这种语言模型,是人类无法理解的黑匣子。我们甚至不知道如何研究它来理解它。

但是如果研究这个黑匣子的不是人类,而是AI本身呢?

这是一个奇怪但非常危险的想法。因为你甚至不知道这种研究方法的结果会不会彻底颠覆人类多年来对人脑和AI的认识。

但是有人做到了。几个小时前,OpenAI发布了最新的研究成果。他们用GPT-4来解释GPT-2的行为,并获得了初步结果。

毫不夸张地说,让人震惊的是:“请让它远离觉醒!”」

“AI理解AI,然后很快,AI训练AI,再过几年,AI创造出新的AI。」

但客观来说,学术界对此感到兴奋:“疯狂,OpenAI刚刚解决了可解释性问题。」

人机之间是GPT 4号。

OpenAI刚刚在官网发表了一篇博文《语言模型可以解释语言模型中的神经元》。

简单来说,他们开发了一个名为GPT-4的工具,以更简单的架构计算其他语言模型中神经元的行为,这次的目标是四年前发布的开源模型GPT-2。

大模型(LLM)和人脑一样,都是由“神经元”组成的。这些神经元会观察文本中的特定规律,进而影响模型本身产生的文本。

例如,如果有一个“漫威超级英雄”的神经元,当用户问模型“哪个超级英雄的能力最强”时,这个神经元会增加模型在答案中告诉漫威英雄的概率。

OpenAI开发的工具利用这个规则开发了一套评估流程。

在开始之前,让GPT-2运行一个文本序列,并等待特定的神经元被频繁“激活”。

然后有三个评估步骤:

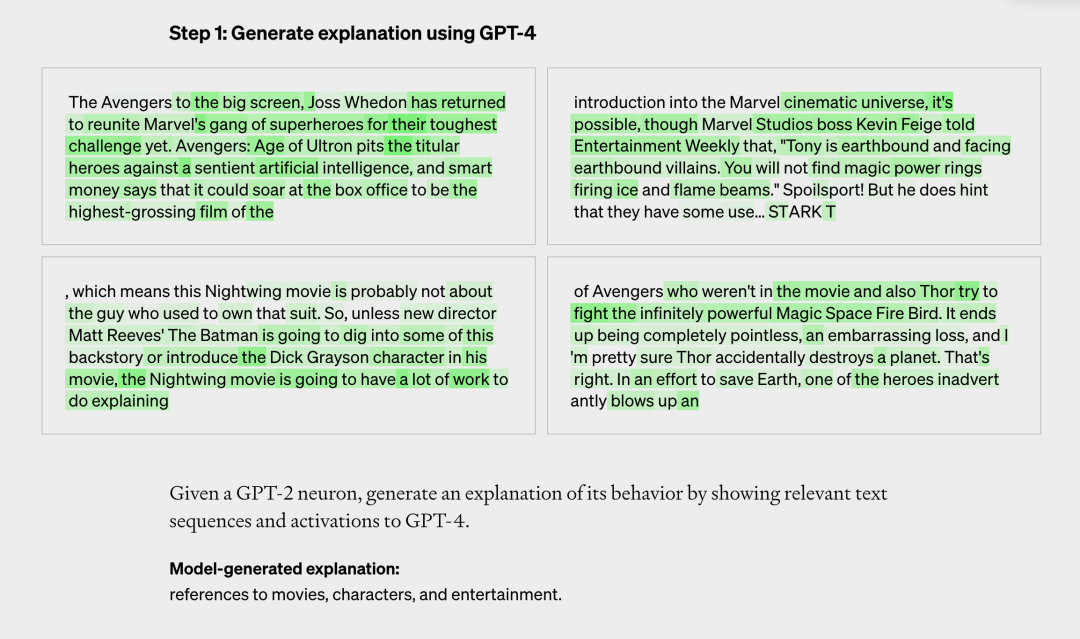

第一步是让GPT-4为这段文字生成一个解释。比如下面这个案例,神经元主要针对漫威漫画内容。在接收到文本和激活后,GPT-4判断它与电影、人物和娱乐有关。

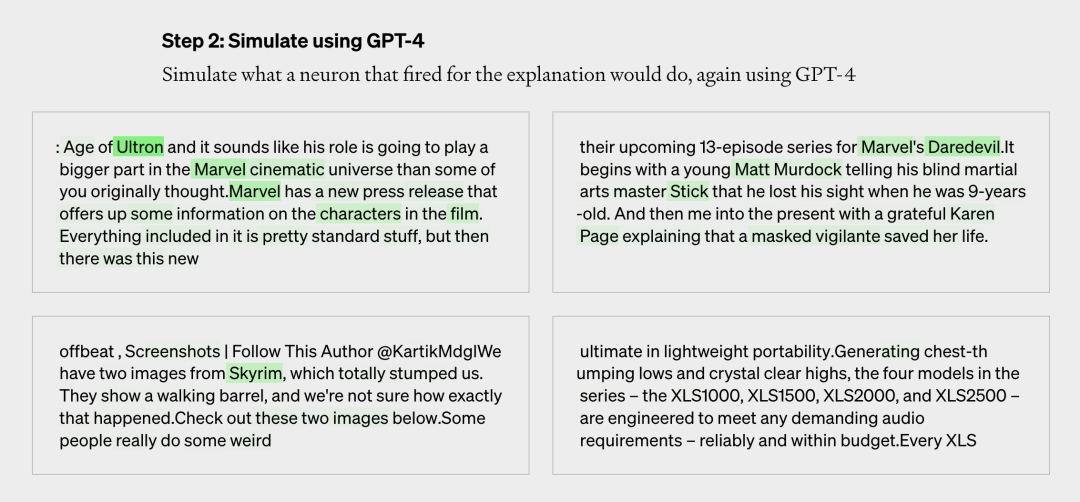

第二步是用GPT-4模拟GPT-2的神经元下一步会做什么。下图是GPT-4生成的模拟内容。

最后一步是比较和评估分数。比较第四代模拟神经元和第二代真实神经元的结果,看看GPT-4有多准确。

OpenAI就这样对每个神经元的行为做出了初步的自然语言解释,并对这种解释与实际行为的匹配程度进行评分。

最后,他们解释了GPT-2中所有的307,200个神经元,这些解释被汇编成一个数据集,与工具代码一起发布在GitHub上。

超越语言的机器,人类无法理解的机器。

OpenAI的博文称,目前GPT-4生成的解释并不完美,尤其是在解释比GPT-2更大的模型时,表现效果很差,“可能是因为后面的层更难解释”。

GPT-2解释的得分也很低,只有大约1000个解释获得了高分(0.8以上)。

OpenAI可扩展比对团队的杰夫·吴(Jeff Wu)表示,“大多数解释的得分都很低,或者无法解释实际神经元的这么多行为。例如,许多神经元以不可预测的方式保持活跃。他们在五六件事情上保持活跃,但是没有可辨别的模式。有时有一个明显的模式,但GPT 4号找不到它。」

虽然现阶段成绩不佳,但OpenAI更有信心。他们认为机器学习可以用来提高GPT-4输出解释的能力。

比如通过反复解读,并根据激活情况修改解读;或者用更大的模型来解释;以及调整解释模型的结构。

OpenAI还提到,这种方法还有很多局限性。

用简短的自然语言解释,可能与神经元的复杂行为不匹配,无法简洁描述。神经元可能有很多不同的概念,也可能有一个人类无法描述甚至无法理解的概念。OpenAI最终希望能够自动找到并解释能够实现复杂行为的整个神经回路,但目前的方法只解释了神经元的行为,不涉及下游影响。它解释了神经元的行为,但没有解释这种行为的机制。这意味着即使你得了高分,你也只能描述相关性。整个过程计算量很大。在论文中,OpenAI说:“语言模型可能代表人类无法用语言表达的陌生概念。这可能是因为语言模型关心不同的事情,例如统计结构对下一个令牌预测任务有用,或者因为模型发现了人类尚未发现的自然抽象,例如不同领域的相似概念族。」

它把LLM的这种属性称为异类特征,翻译成生物学领域的“异类特征”。

方正朴在后台回复“讲解神经元论文”,获取论文链接和中英文PDF链接(机器翻译)。

把对齐问题也交给AI吧

“我们正试图开发一种方法来预测‘人工智能系统将会发生什么’,”OpenAI可解释团队的负责人威廉·桑德斯(William Saunders)告诉媒体。“我们希望真的去做,让这些模型的行为和生产答案可以被信任。」

山姆·奥特曼(Sam Altman)也转发了一篇博客文章说:GPT 4号为GPT 2号做了一些解释工作。

可解释性是机器学习的一个研究子领域,是指对模型的行为有清晰的理解,以及理解模型结果的能力。

简单来说,目的就是解释机器学习模型的“如何”。

自2019年以来,可解释性成为机器学习的重要领域,相关研究有助于开发者优化和调整模型。针对当前AI模型大规模应用时急需解决的信任、安全、决策等问题。

如果我们不知道AI是如何做决策的,总是把它当成一个黑匣子,那么即使AI在各种场景下表现完美,也无法解决一些人类的信任问题。

OpenAI这次用GPT-4解决可解释问题,希望用自动化让机器完成AI研究。

“这是我们比对研究的第三个支柱的一部分:我们希望自动化比对研究。期待的是这个方向能让它(align)与AI发展的步伐相匹配。」

2022年夏天,OpenAI发表了《我们的比对研究方法》一文。

文中提到,从宏观角度来看,OpenAI的比对研究将由三大支柱支撑:

1.用人工反馈训练AI。

2.训练人工智能系统辅助人类评估。

3.用于比对研究的训练人工智能系统。

“语言模型非常适合自动比对研究,因为它们通过阅读互联网‘预装’了大量关于人类价值观的知识和信息。跳出框框,他们不是独立的,所以他们不会在世界上追求自己的目标。」

太快了,连认知都是范式革命。

虽然OpenAI的本意是好的,但这样的研究结果确实吓到网友了。

OpenAI的推文满天飞,很多人都在认真的建议OpenAI减速。

“用我们不理解的东西去解释另一个我们不理解的东西合理吗?」

“你拆掉了所有的护栏。”

“这很迷人,但也让我感到极度不适。」

“自然创造了人类来了解自然。我们创造了GPT 4号来了解我们自己。」

“我们怎么能判断口译员是好的呢?这就像& # 8230;谁监督监督者?」(谁看守望者)

其他人看到了更深的一层:

“大模型很快就能比人类更好地解释自己的思维过程。不知道未来我们会创造出多少新词来描述AI发现的概念(概念本身并不准确)?我们还没有一个合适的词来描述它们。或者我们会发现这些概念有意义吗?他们如何教会我们如何认识自己?」

另一位网友回应道:“对人类行为的解释大多是谎言、捏造、幻觉、错误记忆和事后推理,就像AI一样。」

本网站声明:网站内容来源于网络。如有侵权,请联系我们,我们会及时处理。

温馨提示:注:内容来源均采集于互联网,不要轻信任何,后果自负,本站不承担任何责任。若本站收录的信息无意侵犯了贵司版权,请给我们来信(j7hr0a@163.com),我们会及时处理和回复。

原文地址"open ailab,open ai":http://www.guoyinggangguan.com/qkl/150285.html。

微信扫描二维码关注官方微信

▲长按图片识别二维码